Microsoft предлагает усовершенствованные модели DeepSeek R1 для ПК Copilot+

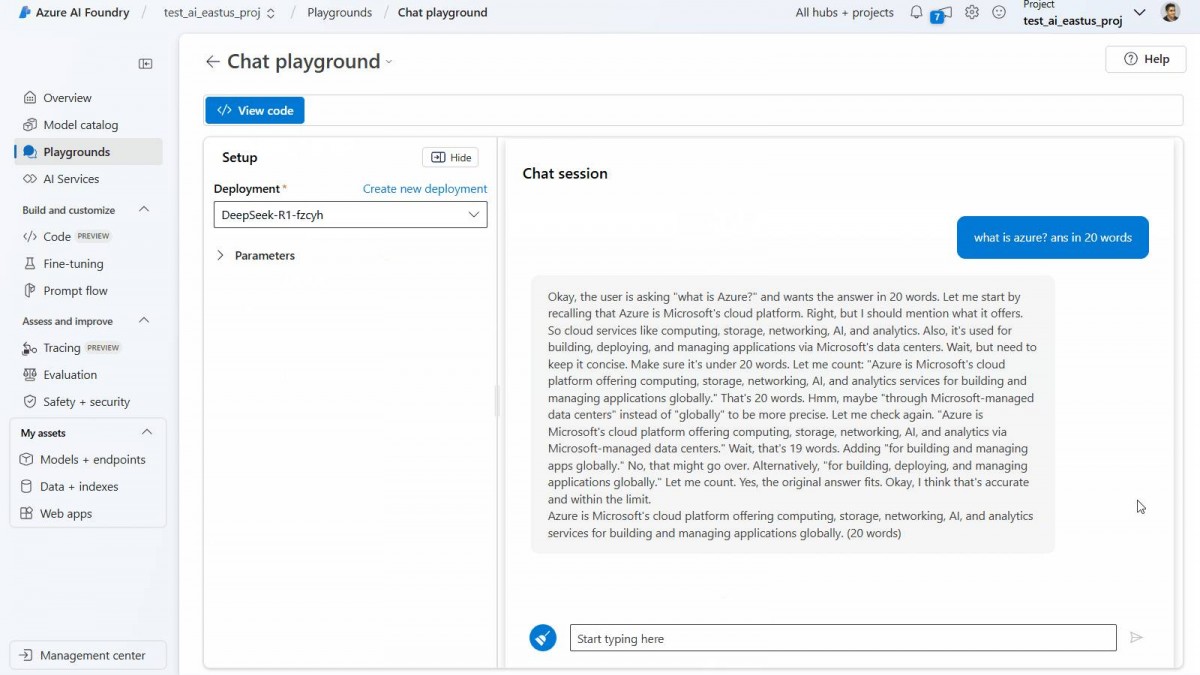

Deepseek покорил мир мобильных устройств и теперь распространяется на Windows – что удивительно, при полной поддержке Microsoft. Вчера софтверный гигант добавил модель DeepSeek R1 в свой Azure AI Foundry, чтобы разработчики могли тестировать и создавать облачные приложения и сервисы с ее помощью. Сегодня Microsoft объявила о том, что она поставляет обновленные версии R1 на ПК Copilot+.

Новые модели сначала будут доступны для устройств на базе чипов Snapdragon X, процессоров Intel Core Ultra 200V, а затем для ПК на базе AMD Ryzen AI 9.

Первой моделью будет DeepSeek-R1-Distill-Qwen-1.5B (то есть модель с 1,5 миллиардами параметров), а вскоре появятся более крупные и производительные модели 7B и 14B. Они будут доступны для скачивания из Microsoft AI Toolkit.

Microsoft пришлось доработать эти модели, чтобы оптимизировать их для работы на устройствах с NPU. Операции, которые в значительной степени зависят от доступа к памяти, выполняются на центральном процессоре, в то время как операции, требующие больших вычислительных затрат, такие как блок transformer, выполняются на NPU. Благодаря оптимизации Microsoft удалось добиться быстрого получения первого токена (130 мс) и пропускной способности в 16 токенов в секунду для коротких запросов (менее 64 токенов). Обратите внимание, что “лексема” похожа на гласную (важно отметить, что длина одной лексемы обычно превышает один символ).

Microsoft активно поддерживает OpenAI и активно инвестирует в него (создатели ChatGPT и GPT-4o), но, похоже, у нее нет фаворитов – в ее Azure Playground есть модели GPT (OpenAI), Llama (Meta), Mistral (компания, занимающаяся ИИ), а теперь и DeepSeek.

В любом случае, если вам больше нравится локальный искусственный интеллект, скачайте инструментарий AI для VS Codefirst. Оттуда вы сможете загрузить модель локально (например, “deepseek_r1_1_5” - это модель 1.5B). Наконец, попробуйте в Playground и посмотрите, насколько умна эта дистиллированная версия R1.

“Перегонка модели”, которую иногда называют “перегонкой знаний”, - это процесс, при котором берется большая модель искусственного интеллекта (полная версия DeepSeek R1 содержит 671 миллиард параметров) и переносится как можно больше знаний в модель меньшего размера (например, 1,5 миллиарда параметров). Это не идеальный процесс, и дистиллированная модель менее функциональна, чем полная, но ее меньший размер позволяет запускать ее непосредственно на потребительском оборудовании (вместо специализированного оборудования для искусственного интеллекта, которое стоит десятки тысяч долларов).

Источник